¡Hola!

Soy Javier Fuentes y te doy la bienvenida a esta nueva edición de The Independent Sentinel. Aprovechando que esta es nada más y nada menos que la edición #50 de la newsletter, hoy vamos a romper con la estructura habitual de la misma para hablar en profundidad sobre el futuro de la Inteligencia Artificial y los distintos caminos que se plantean para llegar a la Inteligencia Artificial General (AGI).

¡Comenzamos nuestra andadura! 👣

🎼 Quieres banda sonora? ¡Dale al Play!

👣 Q*uo Vadis

📖 Índice

Exponenciales y Sigmoides

Los caminos hacia la AGI

La fuerza bruta: Acero, silicio y energía

El velo de la ignorancia

Más vale maña que fuerza

Strawberry Fields Forever

Q*uo Vadis?

📈 1 Exponenciales y Sigmoides

Ya en el primer monográfico de The Independent Sentinel publicado a finales de 2022, hablaba sobre el fenómeno de crecimiento tecnológico exponencial que estamos viviendo causado por el efecto de “composición”.

Transcurrido más de un año y medio, es imposible negar que este crecimiento ha venido siendo tan rápido como se podía esperar desde entonces y, aparentemente, exponencial.

A la vista de la gráfica, la apariencia de exponencialidad del fenómeno es evidente, tal y como ya intuyó Jacob Bernoulli al estudiar el interés compuesto. Las funciones exponenciales recrean de manera ajustada aquellas magnitudes en las que una cantidad crece o decae a una tasa proporcional a su valor actual.

Las preguntas que tenemos ahora tras meses de crecimiento sostenido no son ya tanto relativas al crecimiento de los sistemas de IA (no solo de los LLMs) sino a cómo de sostenible puede ser en el tiempo, ¿existe algún límite para este crecimiento desatado? ¿estamos realmente montados en una curva exponencial?.

Frente a la idea de crecimiento ilimitado de la exponencial, tenemos otra curva idónea para representar el crecimiento presente en muchos procesos naturales y sistemas complejos: La curva S o función sigmoide.

La curva S muestra como un proceso de crecimiento arranca de manera gradual en su inicio, tiene un periodo de transición de fuerte crecimiento que se asemeja a una exponencial y desemboca en una fase en la que el crecimiento se estanca y llega a una meseta o “plateau” en inglés.

¿Cómo es esta montaña rusa en la que estamos subidos? ¿Sigmoide o exponencial? ¿En qué fase de esa subida estamos? ¿Cerca del comienzo o cerca de la meseta en el caso de curva S?

A día de hoy tenemos opiniones que apuntan en ambas direcciones, hay expertos que piensan que es posible que haya un crecimiento ilimitado (la IA es una tecnología distinta a cualquier otro descubrimiento de la humanidad) mientras que otros indican que en algún momento llegaremos a la meseta. Llevándolo al caso de los LLMs, muchos piensan que estamos ya en esa meseta y que habrá que buscar nuevos medios para seguir avanzando.

En la edición de hoy profundizaremos en las alternativas de crecimiento de la IA para entender mejor dónde estamos y, si esto fuese posible, vislumbrar hacia dónde vamos.

🤖 2 Los caminos hacia la AGI

Saber en qué tipo de curva estamos y en qué punto de la pendiente de la misma es un problema inaprensible ya que, con la información del presente, es un labor casi imposible predecir que ocurrirá en el futuro, más aún estando en un periodo de rápida evolución tecnológica.

No obstante, si que podemos analizar los dos principales caminos que, a día de hoy, creo que pueden guiar el crecimiento y avance de la Inteligencia Artificial y ayudarnos al menos a intuir en dónde nos encontramos.

Tenemos tres alternativas para encontrar la solución:

La fuerza bruta (aplicación intensiva de recursos para dar con la solución)

La creatividad (búsqueda de técnicas y procedimientos que proporcionen la solución)

Una combinación de las anteriores

Los grandes modelos de lenguaje (LLMs) son un caso paradigmático de un acercamiento mixto a la solución. El logro tecnológico vino dado de la mano de fuerza bruta (computación + gran corpus de entrenamiento) y de creatividad (la nueva arquitectura Transformer)

Veamos con más detalle cómo se está planteando el futuro de estos acercamientos en el mundo de la Inteligencia Artificial:

La pura infraestructura

Las nuevas arquitecturas

Profundicemos en estos enfoques.

🛠 3 Acero, silicio y energía

🪜 La hipótesis del escalado

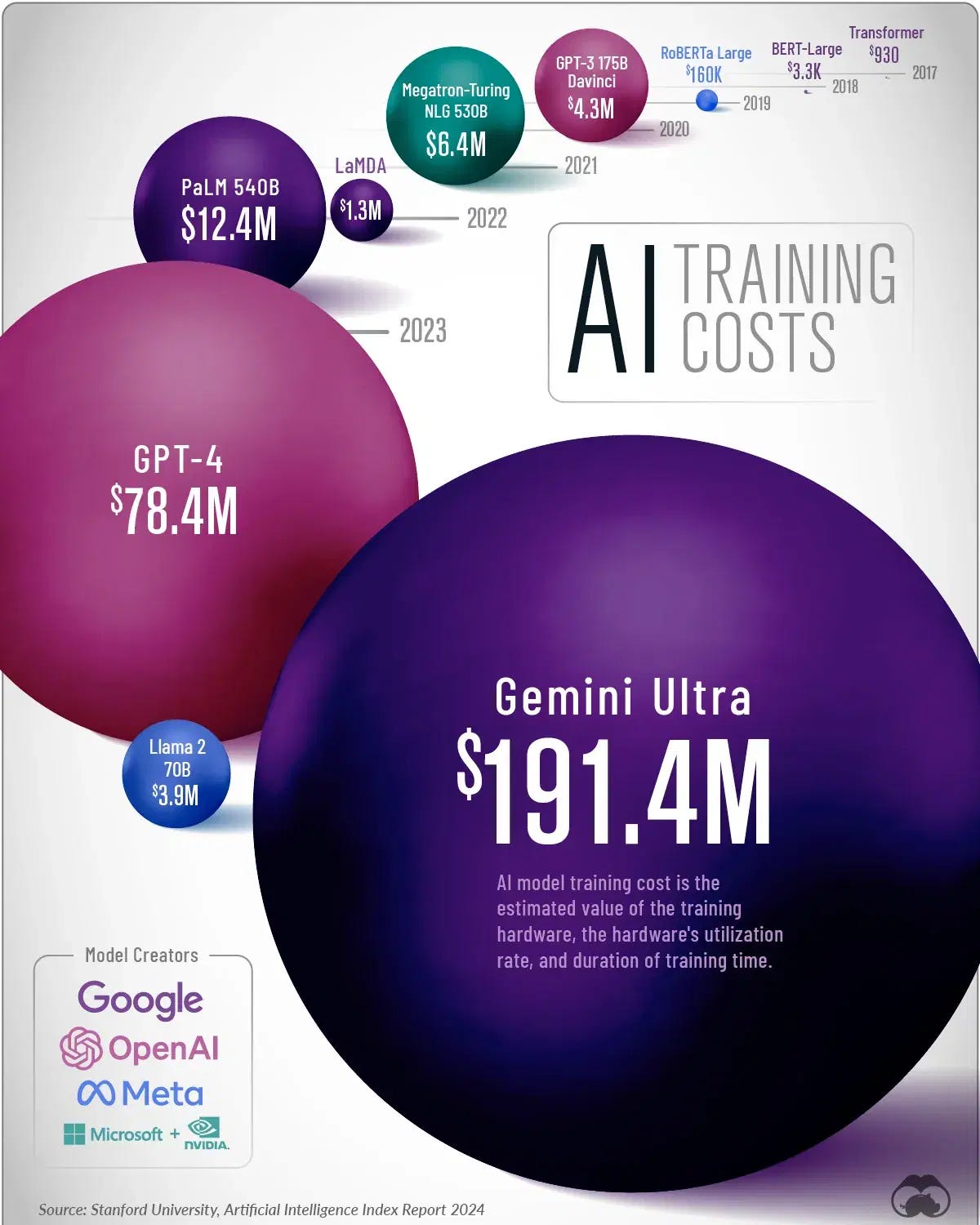

Este primer camino de avance por “fuerza bruta” computacional viene motivado por la “hipótesis del escalado”. Esta hipótesis supone que, a mayor computación volcada en el entrenamiento de unos modelos cada vez más grandes, mayor número de capacidades emergentes obtendremos tal y cómo ha venido ocurriendo desde GPT-3.

Seguramente, el descubrimiento más relevante de los últimos años en el mundo de la tecnología ha sido la revelación de que, a mayor computación, somos capaces conseguir mayores niveles de “inteligencia” o capacidad de razonamiento de los modelos de IA.

Como comentábamos en la sección anterior, el avance de los LLMs vino motivado por la coincidencia en el tiempo de diversos factores de diversa naturaleza: disponibilidad masiva de datos, computación accesible y una nueva arquitectura que dio sentido a la combinación de lo anterior.

Esta intuición parece obvia ahora, pero no siempre es algo que se haya tenido claro en el campo de la ciencia de datos. Este incremento de inteligencia por computación, esta “fuerza bruta”, puede ser correlacionada con el tamaño de los modelos mediante el número de parámetros en los LLMs.

Debe tenerse en cuenta que, a mayor número de parámetros en una red neuronal, mayor es el coste computacional del entrenamiento.

Hace muy poco, Dario Amodei, CEO de Anthropic, exponía esta hipótesis del escalado de manera perfectamente entendible:

Según expone Amodei, la "inteligencia” de un modelo estaría directamente relacionada con el coste del entrenamiento:

Modelo de $100 millones: Inteligencia de un estudiante de secundaria

Modelo de $1 billón: Inteligencia de estudiante universitario

Modelo de $10 billones: Inteligencia de un estudiante brillante ya graduado

Modelo de $100 billones: Inteligencia de un premio Nobel

Como se puede comprobar, hará falta mucha, mucha computación para validar esta hipótesis.

🏢 Brick & mortar

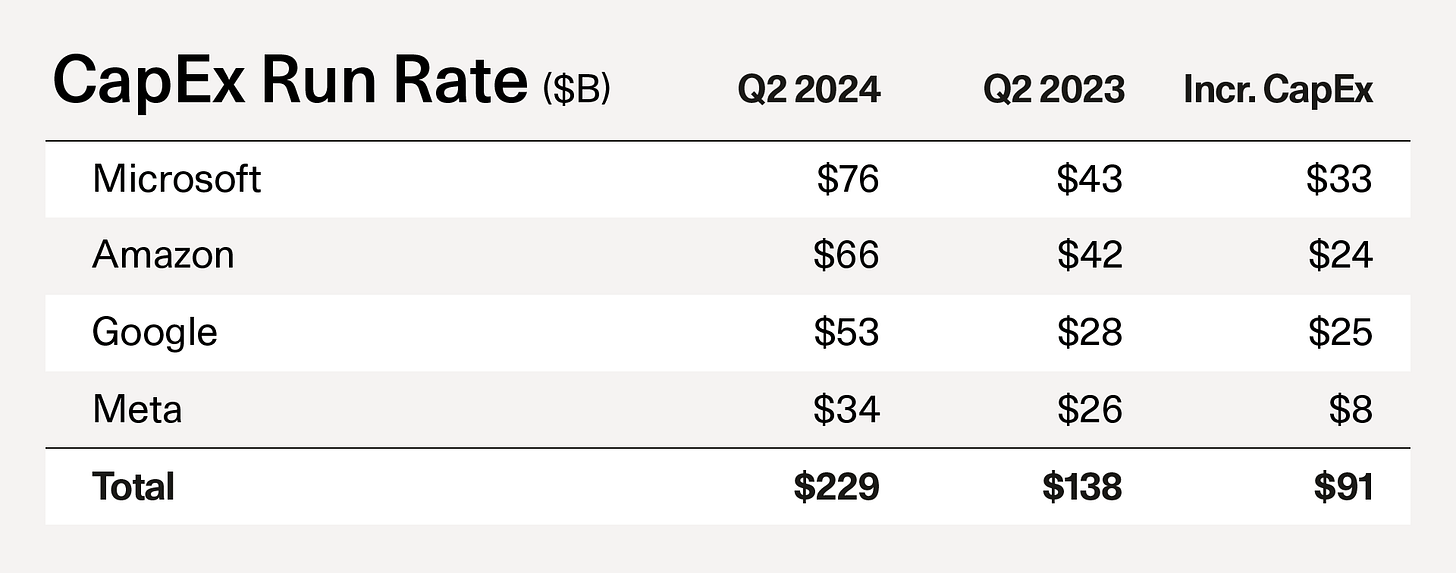

Como puedes intuir, el avance de los sistemas de IA en este contexto vendrá determinado por criterios que tiene que ver con la infraestructura y no tanto con la técnica.

Es justamente esto lo que explicaba en este excelente artículo David Cahn, partner en Sequoia Capital. En el mismo, Cahn expone su tesis respecto al futuro de la IA y, en su opinión, la siguiente fase con la que nos encontraremos tendrá más que ver con la construcción en el mundo físico que con el avance científico.

The race to model parity has been the defining project of the last 12 months in AI. This phase was characterized by the search for new research techniques, better training data and larger cluster sizes.

The next phase in the AI race is going to look different: It will be defined more by physical construction than by scientific discovery.

David Cahn (

)

Este enfoque basado en la infraestructura es obviamente intensivo en capital, como demuestra la evolución del CapEx de las principales tecnológicas.

Un reflexión interesante a este respecto es que, estas inversiones, darán frutos a uno o dos años vista debido al tiempo necesario para:

a) La construcción de estos nuevos y sofisticados Data Centers y

b) El entrenamiento y despliegue de esos nuevos modelos que esperamos sean mucho más grandes y potentes que los actuales.

No es únicamente un asunto tecnológico, el ganador de esta batalla será aquel que sea capaz de ejecutar y escalar líneas de negocio que permitan conseguir retornos de esta gran apuesta en CapEx.

👰🏻♀️ 4 El velo de la ignorancia

Centrémonos ahora en el camino alternativo para el progreso de la IA, el avance científico.

Seguramente recuerdes el culebrón de Sam Altman y OpenAI que ocurrió en Noviembre del año pasado y en el que, aunque parezca mentira, todo ocurrió en menos de una semana. Quién sabe si no se acabará haciendo alguna serie televisiva sobre todos los sucesos que acontecieron en esos días del otoño pasado.

Esta fue la sucesión de los hechos:

Mucho se ha hablado de las razones por la que se produjo la salida de Altman de OpenAI pero, a tenor de lo que se ha venido sabiendo, parece que lo que precipitó los acontecimientos fue un descubrimiento que se produjo en OpenAI.

El mismo día que Altman regresó a OpenAI, en Reuters se publicaba un artículo en el que se daba cuenta de supuestas filtraciones internas provenientes de investigadores de la compañía en las que se avisaba de un poderoso descubrimiento que podría ser -y cito literalmente- “potencialmente peligroso para la humanidad”.

La razón de estas filtraciones era el miedo de una parte del personal de OpenAI de liberar y comercializar un modelo sin ser totalmente conscientes de las consecuencias que esto podría conllevar.

Estas cautelas y miedos parece que son compartidos por parte de la organización, recordemos que Altman es un emprendedor de pura cepa y es bien conocida su voluntad de avanzar de manera decidida y -rápida- en el camino a la AGI, estrategia que no parece compartir parte de la directiva.

Basta con ver las salidas de directivos, investigadores y responsables de seguridad de OpenAI para entender que hay, al menos, dos “vertientes” o bandos con opiniones distintas sobre cómo se debería avanzar en la búsqueda de la AGI.

NOTA: El concepto P(doom) que aparece en el gráfico de arriba, refleja la probabilidad de una AGI con resultados catastróficos para la humanidad. 💀

No sabemos con certeza qué han visto en las investigaciones y tampoco las razones precisas para el abandono, pero es innegable que existe un patrón y una confrontación con las decisiones estratégicas de Altman.

Lo que si sabemos a ciencia cierta es que algo se descubrió en OpenAI es Noviembre y que esa habría sido la cuarta vez que Altman había presenciado como se “retiraba el velo de la ignorancia”, es decir, habría presenciado un avance significativo en la historia de la tecnología humana.

🧠 5 Más vale maña que fuerza

¿Y si no todo fuese cuestión de datos y computación a escala? Tal y como hemos visto, no es descartable pensar en que avances de tipo científico (e.g. nuevas arquitecturas) puedan cambiar el panorama evolutivo de la IA. Veamos por dónde podría discurrir este avance.

🧱 Los límites de los LLMs

En OpenAI, tras su aplicación práctica exitosa de los Transformers para crear los LLMs que conocemos a día de hoy, sabían de primera mano que el camino complementario a la fuerza bruta pasaba por la creación de nuevos modelos que, con una cantidad similar de datos y computación, mejorasen el rendimiento y capacidades de los sistemas de IA en términos de “inteligencia”.

Si nos fijamos en el caso específico de OpenAI, después del éxito inesperado y sin precedentes de GPT-3, se comenzó la carrera por explotar al máximo las capacidades de estos nuevos LLMs basados en la arquitectura Transformer siguiendo diversas vías para evitar la temida meseta de la sigmoide:

Aumento de tamaño (en número de parámetros) de los nuevos modelos, con el consiguiente incremento en los costes de computación para los modelos.

Multimodalidad, sirva como ejemplo GPT-4o, modelo capaz de procesar texto, imágenes y audio y que, obviamente, ha sido entrenado con estos distintos tipos de datos.

Pese a las sustanciales mejoras de GPT-4/4o con respecto a GPT-3/3.5, en OpenAI han sido y son conscientes de los límites de los LLMs y de que no será posible aumentar las capacidades cognitivas indefinidamente por mera fuerza bruta (más datos de entrenamiento, más parámetros, más computación) ya que hay consideraciones en el propio diseño de la arquitectura Transformer que hacen que estos sistemas tengan problemas con el razonamiento lógico/matemático y que, por tanto, estén limitadas para el “pensamiento” tal y como lo conocemos e interpretamos los humanos.

En palabras del propio Yann LeCun, parece que estamos ya cerca de esa meseta de la sigmoide en lo que a LLMs se refiere:

¿Cómo sería posible aumentar las capacidades de las LLMs? ¿Qué pasaría si les otorgásemos capacidades de exploración?

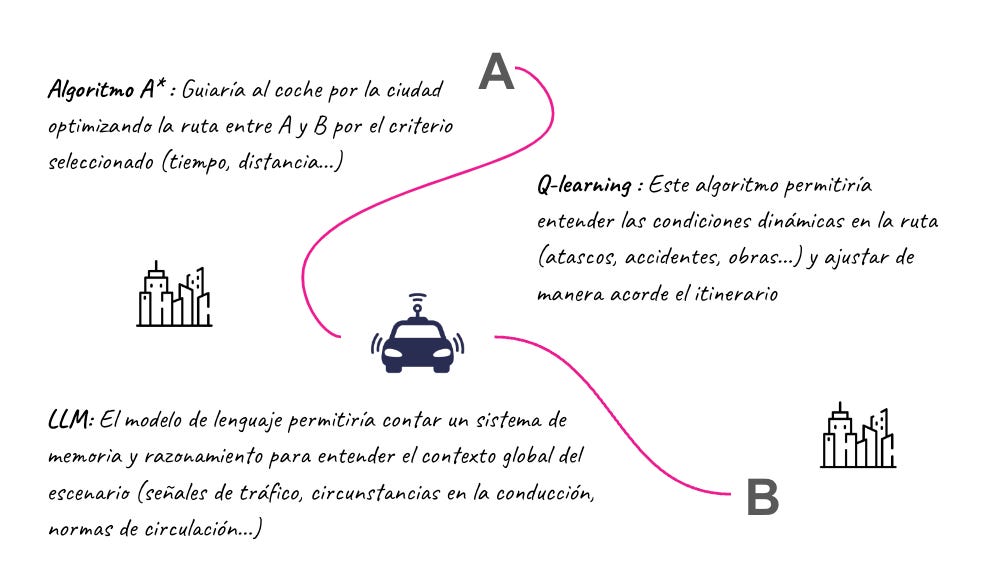

Déjame que te hable de dos algoritmos. Y no, no son algoritmos nuevos y revolucionarios, sino algoritmos conocidos desde hace décadas. Sus nombres son A* y Q-learning. Veamos en qué consisten.

🔎 Algoritmo A*

El algoritmo A* no es más que un algoritmo de búsqueda que se ha venido utilizando para la optimización en entornos complejos. Imaginemos que tenemos un grafo ponderado como el de la figura:

La utilidad del algoritmo A* no es otra que la de identificar de manera analítica cuál es el camino más eficiente para recorrer este grafo. Esta técnica se ha usado no solo en grafos tan sencillos como el de la figura, sino en grafos que representan entornos sumamente complejos como la planificación de ruta en sistemas robóticos.

Este algoritmo tiene obviamente sus limitaciones y es que, por su naturaleza, es incapaz de operar en entornos (representados por grafos) cambiantes o de tener memoria para recordar itinerarios pasados.

Afortunadamente, parece que estas limitaciones pueden ser superadas usando otros algoritmos complementarios, os presento Q-learning.

📝 Q-learning

Q-learning es un algoritmo de RL (aprendizaje por refuerzo) idóneo para trabajar en entornos en los que la experiencia previa y la adaptabilidad son necesarias, justamente los dos puntos débiles de A*.

Q-learning presente el concepto de “recompensa” por cada decisión que se toma en función de cómo de buena es o, en términos de grafos, de cuánto nos acerca al objetivo con el mínimo coste posible.

Además, lo más interesante es que el algoritmo permite maximizar el recompensa a lo largo del tiempo mediante sus repetidas interacciones con el entorno cambiante a través del “mapeo” de todas las posibles acciones o mediante el uso de redes neuronales (el llamado Deep Q-Learning)

Si te fijas por un momento en la fórmula anterior y en la idea de esta búsqueda, verás que estamos ante el paradigma de “Agente”, un sistema capaz de interactuar con su entorno, tomar decisiones y evaluar los resultados de las mismas para aprender.

Como curiosidad, cabe destacar que la “Q” del algoritmo es “quality” y denota la efectividad o idoneidad de escoger un camino en un contexto determinado.

🍹 La coctelera

¿Y qué pasaría ahora si juntáramos A* y Q-learning con los LLMs?

Imagina por un momento un sistema en el que el estado es el prompt que se le ha dado al LLM, la acción es la respuesta completa (no solo la siguiente palabra), y la recompensa es un valor numérico que indica cómo de bien esa respuesta responde al prompt y que sirve como entrenamiento al sistema.

Y no solo eso, imagina que toda esta sucesión de prompts y respuestas viene guiada por un algoritmo de búsqueda como A* que permita la exploración y abordaje un tema complejo, es decir, un LLM con capacidad de buscar y encontrar el camino óptimo (el shortest path) hacia la respuesta correcta usando dos modelos transformer en paralelo (uno para la generación de tokens típica y otro para el cálculo de las recompensas intermedias).

La mejor forma de ver todo esto es con un ejemplo. Imaginemos que nuestro problema complejo a resolver es trazar la ruta de un coche autónomo circulando por la ciudad (equipado con A*, Q-learning y un LLM) para desplazarse de un punto A un punto B.

Es muy interesante la conjunción de un LLM con y Q-learning ya que permite a este último ir más allá de la recuperación de datos, aportando conocimiento y memoria asimilables a las de los humanos y permitiendo por ello la generación de insights y la proposición de ideas.

Este marco conceptual -por ahora teórico- presenta un camino de evolución que podría permitir aumentar las capacidades de los actuales LLMs, haciendo a estos modelos más eficientes y capaces para abordar problemas complejos.

Te estarás preguntando si la unión de estos tres conceptos (A*, Q-learning y LLMs) tiene algún nombre. Pues parece que sí, el nombre es Q* o Proyecto Strawberry.

🍓 6 Strawberry Fields Forever

🕵🏻♂️ Un proyecto misterioso

¿Qué es Q* o proyecto Strawberry? A día de hoy, lo único seguro es que este proyecto de OpenAI es la obsesión de la comunidad de la Inteligencia Artificial.

Cabe destacar que todavía no hay información precisa sobre la naturaleza de este proyecto ya que OpenAI no ha publicado ninguna información oficial sobre el mismo.

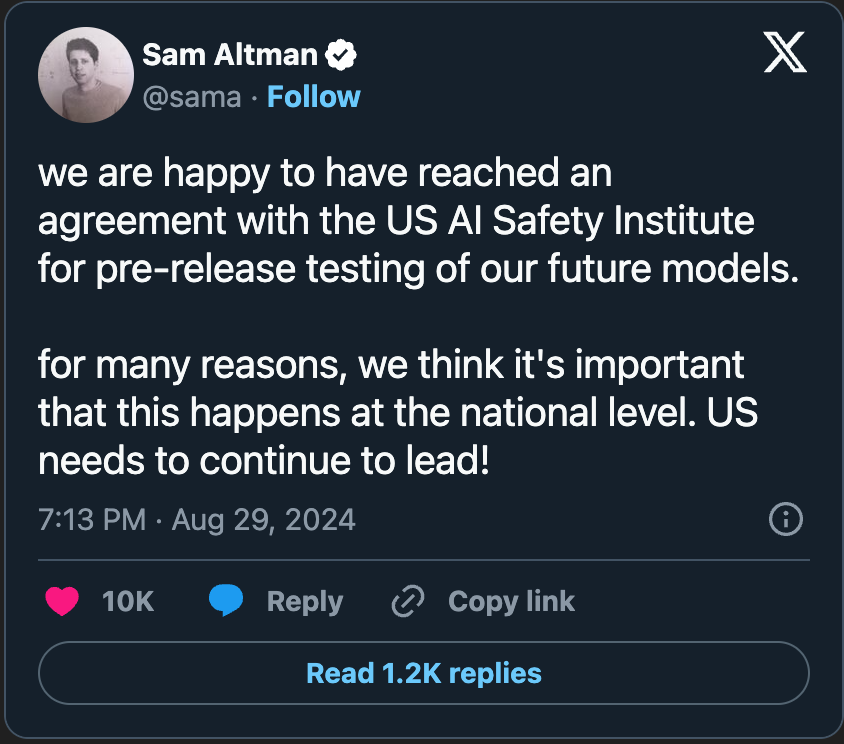

Todo lo que sabemos procede de filtraciones y gran parte de la expectación esta siendo creada por el mismísimo Sam Altman, como atestigua tweets como este que publicó hace unas semanas.

Pero comencemos por el principio. Hoy en día, la IA generativa es fantástica en la escritura, el resumen y la traducción mediante su predicción estadística de la siguiente palabra. En estos casos de uso, hay un numero muy amplio de soluciones posibles y correctas al ser problemas abiertos.

Distinto es el caso de problemas de carácter matemático y analítico, dónde suele haber una única respuesta correcta. Para estos problemas, la IA necesita una capacidad de razonamiento superior parecida a la que tenemos los humanos.

Como ya sabemos, las debilidades de los LLMs están centradas en su capacidad para el razonamiento lógico y la planificación, lo que hace que no sean eficientes a la hora de abordar estos problemas más complejos.

Además, estas capacidades de reflexión y juicio son pre-requisitos que se antojan necesarios para llegar a la AGI (Inteligencia Artificial General) de la que tantas veces hemos hablado y que, por cierto, no tiene aún una definición estándar compartida en el mundo de la IA.

Como se mencionaba en el articulo de Reuters, aparentemente, este nuevo modelo Q* habría sido capaz de, dados ingentes recursos computacionales, resolver problemas matemáticos de manera autónoma, dando un prometedor futuro a Q* ya que, si se dispone de un modelo capaz de “hacer matemáticas”, se dispondrá de la herramienta definitiva para la:

Generación de nuevo conocimiento,

Generación de datos sintéticos (lo que a día de hoy es una barrera para las mejoras de los modelos)

Auto-mejora y optimización de los propios modelos

Se sabe que Jakub Pachocki and Szymon Sidor, dos investigadores senior de Open AI, habrían usado el trabajo previo de Ilya Sutskever para construir este modelo Q* (pronunciado “Q-Star”) que, como comentaba, fue capaz de solventar problemas matemáticos que no había visto antes.

👨🏼🏫 El profesor Kahneman

Hagamos una pequeña parada en el camino. El pasado Marzo, fallecía a los 90 años Daniel Kahneman, un psicólogo israelí ganador del premio Nobel por sus estudios en la toma de decisiones y, además, uno de los padres de la economía conductual (“behavioral economics)”.

En su obra más popular, “Pensar rápido, pensar despacio” publicada en 2011, Kahneman exploraba cómo los humanos tomamos decisiones, identificando en su análisis dos “modos” de pensamiento:

Sistema 1: Rápido, instintivo y emocional

Sistema 2: Lento, deliberativo y lógico

Si nos fijamos por un momento, los actuales LLMs tiene más que ver con sistema del tipo 1, rápida inferencia sin altas capacidades lógicas.

No seríamos capaces de resolver un problema matemático complejo por nuestra propia intuición (asimilable al entrenamiento), sino que necesitamos habilidades de planificación, de división de la complejidad en partes y de razonamiento analítico y lógico para la resolución.

Crear máquinas capaces de pensar como un sistema 2 es ahora mismo el reto por resolver y, probablemente, el proyecto Strawberry sea la respuesta que estábamos buscando.

Pero, ¿cómo podemos hacer este pensamiento reflexivo cuando las soluciones a un problema complejo pueden ser múltiples? Entendamos que son los árboles de pensamientos.

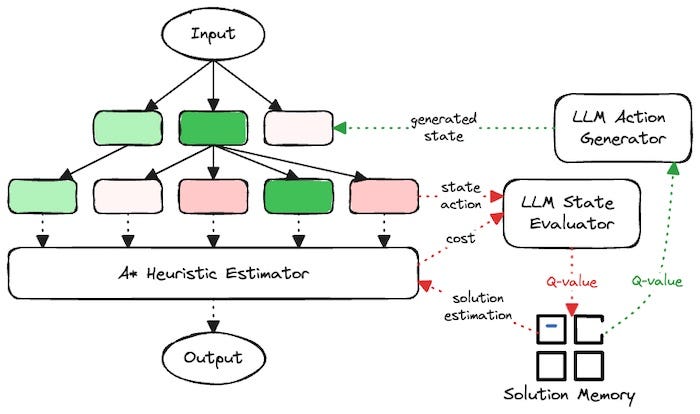

🌳 El árbol de pensamientos

Como estamos viendo, la principal innovación del Proyecto Q*/Strawberry es la capacidad de este nuevo modelo de aprender por sí mismo haciendo uso de algoritmos de búsqueda y de recompensa, dando lugar así a un sistema capaz de realizar pensamiento reflexivo o de Tipo 2 según la clasificación hecha por Kahneman.

Pero para entender por completo la mecánica de este tipo de modelos, nos falta por entender un concepto adicional, el árbol de pensamiento o “Tree of Thoughts” (ToT) que fue presentado en este paper a mediados del año pasado.

El framework ToT es un marco de trabajo que, usando junto con Q*, ofrecería la posibilidad de que el LLM fuese capaz de generar, evaluar e iterar sobre un conjunto de diferentes ideas o soluciones para un problema o reto de partida.

El proceso consiste en crear una especia de “árbol” en el que cada rama representa las diferentes líneas de razonamiento explorables para dar con la solución.

Para entenderlo un poco mejor, veamos los aspectos más relevantes de ToT:

Marco estructurado de resolución de problemas: ToT abstrae el proceso de resolución de un problema genérico en una representación en forma de árbol en la que cada hoja representa una idea.

Estructura idónea para su exploración: Su forma de árbol hace que sea sencillo recorrerlo, como si de un grafo se tratase, por algoritmos de búsqueda como A* y evaluar cada camino como vimos anteriormente

Generados por LLMs: Este árbol sería generado por LLMs capaces de “mapear” la diversidad de pensamientos y caminos para llegar a la solución.

Como se puede ver, este marco encaja como anillo al dedo con Q* y daría lugar a un sistema muy eficaz de resolución, tal y como expone Benny Chaung en este didáctico artículo.

Como se muestra en la figura, podemos ver todos los elementos de Q* en acción dentro del esquema ToT:

El algoritmo A* para la optimización de la búsqueda

Q-learning para la gestión adaptativa vía recompensa

LLMs:

LLM “Generador”: Para la generación de ideas/pensamientos que componen el árbol

LLM “Evaluador”: Para la generación de recompensas

Lo más interesante de esta unión Q* + ToT es que es una técnica autónoma y recursiva capaz de mejorar la resolución de problemas y, seguramente, sea capacidad autónoma y recursiva la que ha levantado las preocupaciones dentro de OpenAI que se reflejan en las salidas de la compañía que hemos visto anteriormente.

Este enfoque daría pie a la creación de sistemas tipo “self-play” (máquinas que juegan contra sí mismas infinidad de veces) que ya han sido aplicados con éxito para aprender, por ejemplo, a dominar juegos (AlphaGo). La diferencia (y el potencial) radicaría en que este enfoque podría usarse no solo para juegos cerrados sino para la resolución de problemas abiertos.

¿Será esto Strawberry? Es una teoría pero aún no podemos asegurarlo.

💭 La era de los Razonadores

Con toda esta información tan difusa es muy difícil comprender en que punto nos encontramos. Desde hace meses, los rumores son continuos y se suceden las “supuestas” filtraciones de empleados de OpenAI con información privilegiada.

A tenor de esta información que vamos recibiendo con cuentagotas, podemos intentar adivinar en qué nivel de madurez se encuentran los sistemas de OpenAI que aún no han hecho públicos.

Hace unos meses, OpenAI lanzó una clasificación de las diversas etapas de madurez de la IA:

Según algunos rumores que han surgido en los últimos días, parece que internamente en OpenAI ya tendrían sistemas de nivel 2, llamados “Reasoners”.

Esto podría parecer poco después de todo lo que estamos hablando pero debemos entender que, si este fuera realmente el caso, estos “Reasoners” podrían catapultarnos rápidamente a los niveles superiores de manera autónoma. Es más, alcanzar cada nivel, hará que el siguiente esté muchísimo más cerca por la capacidades de aprendizaje y descubrimiento autónomo que, esperamos, tengan estas máquinas.

📍 ¿Dónde diablos estamos?

Además de esta filtración, los rumores no han dejado de sucederse. Estos son algunas de las cosas más interesantes (que no estrictamente ciertas) que se están comentando:

Hay fuentes afirman que el proyecto Strawberry ya está listo internamente. La prueba de esto es que, desde ayer, tenemos confirmación por parte de Sam Altman de que el modelo ya ha sido aprobado por agencias federales en EEUU antes de su lanzamiento oficial:

Se dice que Strawberry podría ser lanzado en una versión chat muy limitada

Por otra parte, hay rumores de que Strawberry es en realidad el esperado GPT-5 que se espera sea lanzado a final de este año

Pudiera ser que Strawberry estuviese siendo usado para generar datos sintéticos que permitan entrenar GPT-6, que tendrá en el nombre en clave de Orion 🤯

Por si todo esto te pareciese poco, hay gente especulando incluso con el Roadmap” de capacidades de Strawberry:

Como ves, este misterioso nuevo proyecto se ha convertido ya, antes de ser lanzado, en un meme impulsado por todos aquellos que esperan que este nuevo modelo de OpenAI confirme que, por fin, estamos a un paso de la AGI.

🚨 NOTA: Todo esto son rumores y no hay nada confirmado a este respecto.

🛣 7 Q*uo Vadis?

Una vez expuesto todo lo que sabemos y siendo conscientes de todo lo que desconocemos, nos queda por dar respuesta a las preguntas que hemos ido planteando en esta edición. Intentemos arrojar algo de luz.

¿Qué factores guiarán la evolución de la IA?

Tal y como hemos desarrollado, esta evolución tiene dos vectores principales, la infraestructura y la aparición de nuevas arquitecturas y modelos. Sin embargo, hay un factor que no he mencionado y que, con toda seguridad, será el más relevante de todos: el acceso y coste de la energía.

Tengo la intuición de que obviamos a menudo la alta correlación entre la energía y la riqueza o, como ya está ocurriendo, la correlación entre la energía, la computación y la riqueza.

En el mundo que viene, y como bien explicaba Sam Altman en una entrevista, la abundancia de la energía, determinará la abundancia de la computación y , por ende, acabará definiendo tanto el nivel de sofisticación de la IA como su nivel de presencia en nuestras vidas. Te recomiendo encarecidamente echar un vistazo a este corte de la entrevista de Altman con Lex Fridman.

Todo parece indicar que la IA será la herramienta que nos puede ayudar a entrar en una dinámica de crecimiento (ya veremos si ilimitado o no) mediante la creación de flywheels o bucles realimentados:

Con esto en mente, hagamos un ejercicio de prospectiva a través de futuros escenarios hipotéticos que nos permitan, al menos, reflexionar sobre lo que podría ocurrir:

🏅 Escenario 1: Winner takes all

A nivel corporativo, aquellas empresas capaces de consolidar las infraestructuras más robustas contarán con una mayor capacidad de dar un servicio de calidad a escala, lo que conlleva varias ventajas competitivas:

Mayores ingresos por provisión de servicio

Mayor acaparación de información humana que sirva como base para entrenamiento y RLHF

Este círculo virtuoso podría desembocar en una dinámica winner-takes-all en la que, la compañía o compañías mejor posicionadas obtengan una posición ventajosa debido a:

La acumulación y despliegue efectivo de capital

La creación de nuevos modelos más sofisticados y auto-optimizados como Q*

💥 Escenario 2: Atomización open-source

Otro supuesto escenario, este aún más interesante, sería aquel en el que, suponiendo una disponibilidad futura de energía barata y accesible (hito tecnológico que seguramente la propia IA nos ayude a alcanzar) se descentralizase la creación, entrenamiento y despliegue de modelos de IA.

En este escenario, la computación barata y accesible y el crecimiento del código open-source (no tardaremos en ver al código como una commodity) puede dar lugar a un escenario fragmentado donde una miríada de sistemas, modelos y plataformas conformen un ecosistema tecnológico en el que la IA estará en todas partes y proporcionada por muy diversos proveedores.

📈 ¿Exponencial o sigmoide?

Volviendo al inicio y cerrando el círculo, nos faltaría por reflexionar sobre en qué punto de esa pendiente de crecimiento nos encontramos y de si estamos subidos en una curva exponencial de manera indefinida a o en una sigmoide en la que, en algún momento, llegaremos a la meseta.

Estando tan cerca de crear la tecnología más radicalmente transformadora de la historia, se hace de nuevo difícil hacer predicciones.

Visto de otro modo podríamos pensar en la AGI como “la última innovación hecha por el hombre” ya que, después de este punto singular, la innovación humana habrá muerto y el avance sera realizado por las máquinas y no por nosotros.

Si somos capaces de construir máquinas capaces de implementar estos ciclos de realimentación positiva que guíen la innovación, tal vez saber en que parte de la curva de crecimiento estamos deje de preocuparnos porque habremos alcanzado una prosperidad nunca imaginada por la humanidad. En el fondo, no es tan importante saber dónde estamos, lo importante es seguir avanzando para encontrar esos límites que, si existen, se encuentran aún lejos.

Lo que para mí ya es obvio (y antes no lo era), es que la singularidad es ya inevitable. No sabemos en qué momento la singularidad se hizo inevitable, si fue al crear AlphaGo, las CNNs, los transformers o los modelos de difusión, lo cierto es que hace tiempo que llegamos al punto de no retorno en el avance de la IA.

Si lo miramos con perspectiva, cada día que nos demoramos en llegar a la AGI está costando vidas y sufrimiento para los humanos, nuestra misión y objetivo debe ser acelerar al máximo para que la prosperidad y la abundancia llegué a todo el mundo cuanto antes.

Estamos viviendo un momento mágico en la historia de la humanidad, nuestra capacidad de crear inteligencia sobre silicio es lo más parecido a un milagro que hemos creado como especie.

Y quién sabe, tal vez nada de esto sea casual y nos fue otorgado un planeta repleto de granos de arena por una muy buena razón.

¡Gracias como siempre por leer hasta aquí!

¿Te gusta The Independent Sentinel? ¡Ayúdame a llegar a más entusiastas de la IA!

Si tienes comentarios o quieres iniciar una conversación, recuerda que puedes hacerlo aquí.

Si te has perdido alguna edición de la newsletter o quieres volver a leerlas, puedes acceder a todas aquí.

Si quieres escuchar todas las canciones de The Independent Sentinel, echa un vistazo a esta lista de Spotify.

Uauu! Genial como siempre Javier!

Solo queda esperar estos avances y que sean verdaderamente seguros para la humanidad.

Enhorabuena por este super-artículo.

¡Excelente monográfico Javier!

Mi opinión, muy personal, es que la AI llegará a la singularidad tarde o temprano (y creo que va a ser más temprano que tarde :), logrando una capacidad de razonamiento y creación mucho mayor (veloz, amplia..?), aunque nunca logrará tener “consciencia” (y no le hará falta), pero ahí es donde entra la “conciencia” de su creador humano para mantener bajo control que la AIG no se salga de las manos.