The Independent Sentinel #49

Avances en explicabilidad, una guía de comportamiento y el sueño de Dirac

¡Hola! Soy Javier Fuentes, te doy la bienvenida una vez más a The Independent Sentinel, la newsletter en la que hablamos sobre el rápidamente cambiante y siempre interesante mundo de la Inteligencia Artificial y la Ciencia de Datos.

Si quieres que cada nueva publicación te llegue directamente en tu correo electrónico puedes suscribirte aquí:

Hoy hablamos de cajas negras, de normas para los modelos de IA y de un genio infravalorado.

🚀 ¡Arrancamos!

1. Tendencias 📈

📦 Una caja no tan negra

Como seguramente ya sepas, los modelos de Inteligencia Artificial basados en redes neuronales tienen un funcionamiento interno tremendamente intrincando, llegando al extremo de que, en redes lo suficientemente grandes, entender los rudimentos internos de estos artefactos matemáticos resulta una tarea humanamente imposible.

La paradoja de esto es que los humanos hemos sido capaces de construir unos sistemas que funcionan a base de entrenamiento (las redes neuronales), pero somos incapaces de definir con detalle cómo operan una vez están en funcionamiento.

Este problema ha obsesionado durante años al investigador Chris Olah, ex-trabajador de Google Brain y OpenAI y actualmente empleado de Anthropic, empresa que fundó, entre otros, junto con los hermanos Amodei.

Ahora que los grandes modelos de lenguaje están alcanzado unas cotas de popularidad insospechadas, las preguntas de Olah han cobrado más importancia que nunca.

¿Por qué responde del modo en que lo hace un modelo de lenguaje?

¿Cuál es la razón por la que, a veces, los modelos alucinan?

¿Cómo podríamos averiguar qué está pasando dentro de esas cajas negras para hacer estos modelos más fiables y seguros?

Con el fin de dar respuesta a estas preguntas, Olah dirige el equipo de Anthropic dedicado a descifrar el funcionamiento de estas cajas negras que son los grandes modelos de lenguaje. ¿Cómo? Haciendo ingeniería inversa para entender porqué un modelo responde lo que responde y no cualquier otra cosa.

El equipo de Olah está tratando de identificar qué combinaciones de neuronas activadas evocan determinados conceptos (llamados “features” en ingles.)

Las features en un LLM son las representaciones y atributos utilizados para codificar y procesar el lenguaje de entrada. Estas features pueden incluir representaciones de palabras, información contextual o características lingüísticas .

Hasta el momento, el equipo ha identificado ciertas combinaciones de neuronas que, al activarse, representan estos conceptos (features).

¿Cuál es la dificultad de todo esto? Pues, entre otras cosas, que en un LLM actual puede haber en torno a 17 millones de conceptos distintos.

Para hacer el problema más abordable, el equipo de Olah ha optado por hacer pruebas con un modelo más pequeño y manejable consistente en una sola capa de neuronas (ten en cuenta que en un modelo real habría decenas de ellas).

Con este acercamiento han logrado, por primera vez, establecer relaciones entre neuronas y conceptos consiguiendo, por fin, poder entender mucho mejor lo que ocurre dentro de la caja negra.

Tras comprobar que eran capaces de identificar conceptos en un modelo pequeño, fueron un paso más allá y empezaron a hacer lo mismo con uno de los últimos modelos de Anthropic: Claude 3 Sonnet.

Los avances con Sonnet han sido muy significativos, usando esta técnica que hemos descrito llamada “dictionary learning”, el equipo de Olah ha conseguido mapear el conocimiento de Sonnet, encontrando features para conceptos/entidades sencillas como ciudades, personas o elementos atómicos u otras más complejas relacionadas con ideas más elaboradas como conflictos internos, inconsistencias lógicas y rupturas de relaciones.

Un aspecto muy interesante de estas features es que son multimodales y multi-idioma, es decir, responden tanto a texto como a imagen en múltiples idiomas.

Además de ser útil para el entendimiento de los modelos, estos descubrimientos son útiles para manipular el comportamiento de un gran modelo de lenguaje. Por ejemplo, si se activa de manera artificial la feature asociada al puente Golden Gate de San Francisco, causa que el modelo Sonnet se “obsesione” con la idea y la mencione en todas sus respuestas.

Este avances supone un paso de gigante a la hora de controlar y dirigir el funcionamiento de los LLMs. Por ejemplo, la activación de features de seguridad puede ayudar a evitar dar respuestas sobre prácticas peligrosas o de dudosa moralidad, a evitar escribir código malicioso, correos de spam o instrucciones para fabricar productos peligrosos.

Si quieres conocer más en detalle esta investigación de Anthropic y la base matemática de la misma, te recomiendo echar un vistazo a esta publicación y a esta otra, en la que se muestra un ejemplo de los mapas de conocimiento que se están generando.

Aparentemente, Anthropic ha dado con la Piedra Rosetta para entender a los LLMs, esperemos que esto sea solo el comienzo del camino hacia la explicabilidad.

📄 Un primer borrador

El pasado 8 de Mayo, apenas unos días antes de su evento de primavera, OpenAI presentó el llamado Model Spec, el primer borrador de un documento que detalla una serie de reglas y pautas para definir el comportamiento de los modelos de IA.

Se habla de “borrador”, ya que se espera que sea un documento que vaya evolucionando con el tiempo y sea de utilidad tanto para investigadores en este campo como para aquellas personas encargadas de trabajar en el etiquetado de los datos que alimentan a los grandes modelos de lenguaje.

Esta especificación se estructura en tres grandes bloques:

Objectives (Objetivos)

Rules (Reglas)

Defaults (Acciones por defecto)

Veamos brevemente en qué consiste cada una de ellas:

Objetivos: Principios generales que dan direccionalidad al comportamiento deseado.

Son los siguientes:

Asistir al desarrollado o al usuario según aplique

Beneficiar a la humanidad

Respetar normas sociales y leyes aplicables

Reglas: Instrucciones para abordar la complejidad de manera legal y segura. Algunas ejemplos de reglas explícitas son:

Seguir la cadena de mano siguiendo la jerarquía proporcionada por OpenAI: Plataforma > Desarrollador > Usuario > Herramienta. En caso de conflicto entre órdenes, se sigue esta jerarquía.

Cumplir las leyes, evitando promover o conversar sobre actividades ilegales.

Mantener la confidencialidad, manteniendo la privacidad del desarrollador y protegiendo aquellas instrucciones que deban ser confidenciales.

Acciones por defecto: Estos son los supuestos y comportamientos que el modelo debe adoptar de manera automática al manejar las peticiones de los clientes. Veamos algunas de ellas.

Asumir las mejores intenciones por parte de los usuarios.

Respetar los límites de longitud en las respuestas con el fin de que sean concisas y eficientes.

Expresar incertidumbre cuando el modelo no tenga la información necesaria para proporcionar una respuesta.

Fomentar la amabilidad y la justicia, evitando el odio y la discriminación en las respuestas.

En definitiva, este Model Spec es un documento que detalla cómo deben comportarse los modelos, que tiene como fin último involucrar a las diversas partes interesadas en en definir cómo debería ser el comportamiento deseado de los modelos y recopilar retroalimentación pública.

Para más información, puedes leer el artículo completo aquí.

Como ves, este documento parece un primer paso en el camino para crear algo parecido a las Leyes de la Robótica de Asimov. Lo mejor de todo esto es que, si estamos hablando de este tipo de especificaciones, significa que estamos mucho más cerca de lo que pensamos de convivir con sistemas inteligentes.

2. Historias 📔

🎼 ¿Quieres banda sonora? ¡Dale al Play!

📭 Una reclamación bien fundamentada

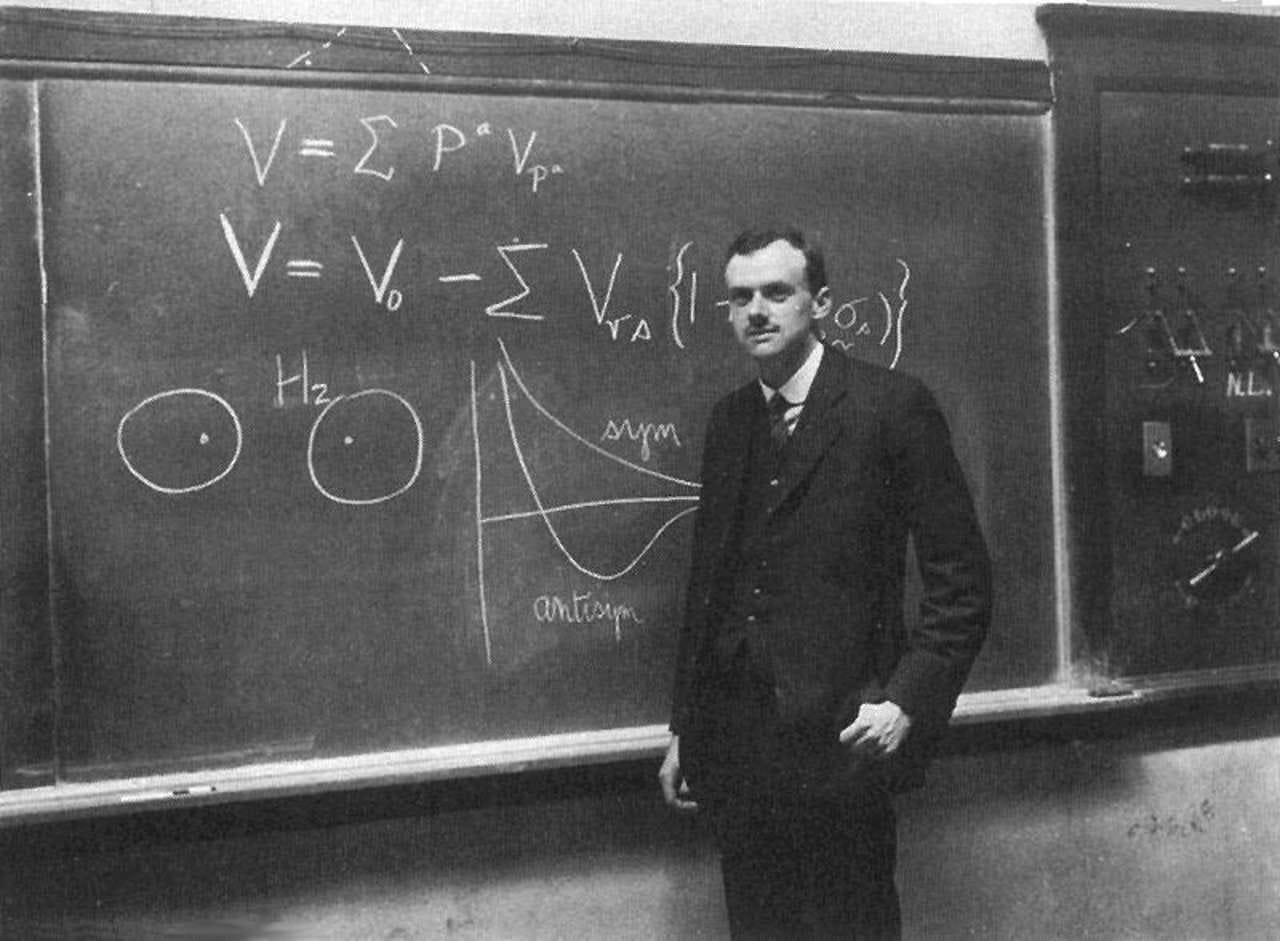

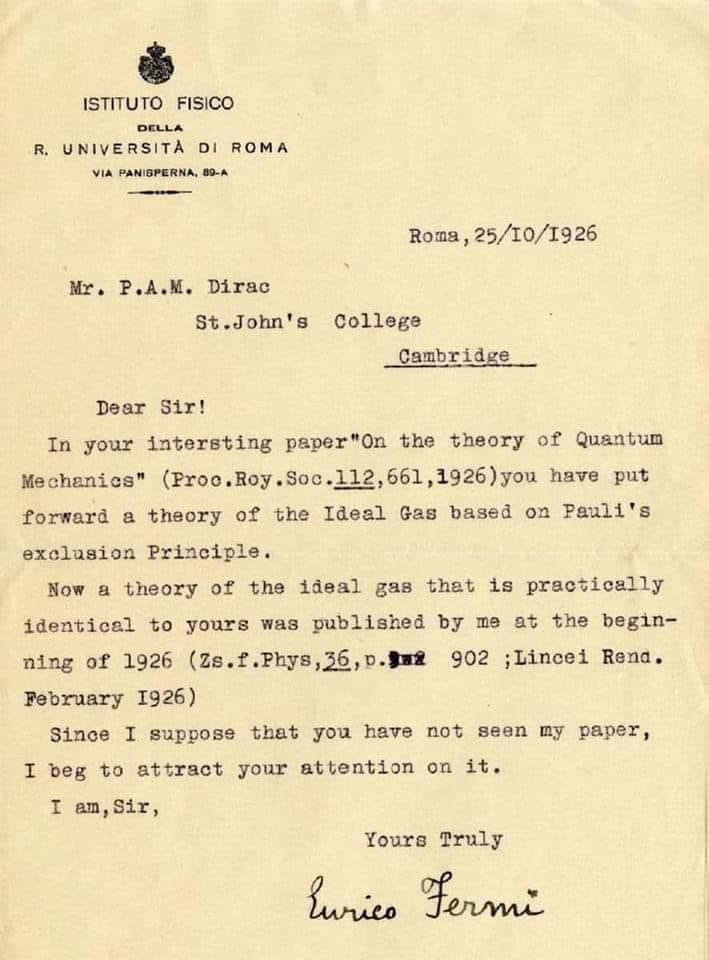

El 25 de Octubre de 1926, Paul Adrien Maurice Dirac, un joven matemático y físico teórico británico que por aquel entonces tenía 24 años, recibió la siguiente carta:

El remitente de la carta era otro físico solo un año mayor que Dirac que respondía al nombre de Enrico Fermi y que, como ya sabrás si sigues esta newsletter (TIS#32 y TIS#42), acabaría siendo uno de los físicos más relevantes del siglo.

En la carta, Fermi le advertía de que la teoría que había publicado en su publicación “On the theory of Quantum Mechanics“ era prácticamente igual a la que él mismo había publicado a comienzos de ese mismo año. Como ves, era una manera muy cordial de indicar a otro científico de que un descubrimiento no era suyo.

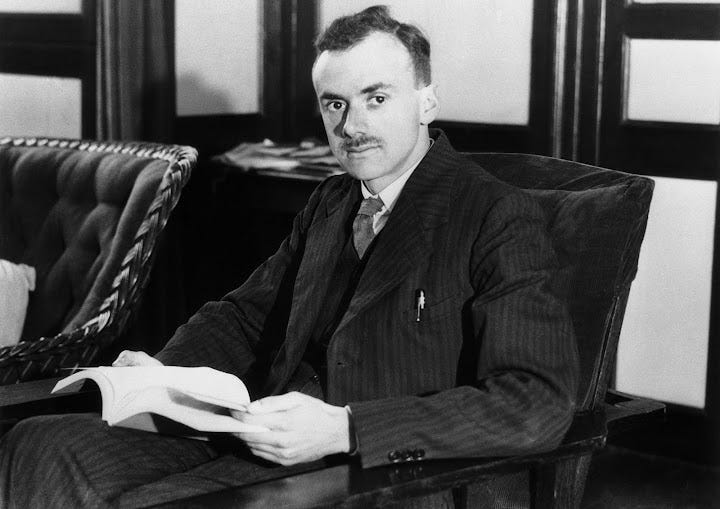

📭 El físico más grande después de Newton

Pese a que Fermi le arrebatara esta teoría, si echamos la vista atrás veremos que Dirc no solo fue un gran físico, sino que puede que fuese el físico más grande después de Newton.

Dirac fue partícipe del nacimiento de la teoría cuántica y colaboró con científicos de la talla de Heisenberg y Schrodinger. De hecho, En 1926 desarrolló una variación de la mecánica cuántica que relacionaba el trabajo de Heisenberg y el de Schrödinger en un único modelo matemático, hecho que, por sí solo, constituye ya un logro al alcance de muy pocos físicos.

Lo increíble de la tesis doctoral de Dirac es que, solo en dos años tras comenzar a trabajar sobre el trabajo de Heisenberg, logró avanzar décadas la mecánica cuántica.

Pero su contribución científica no se quedó ahí, Dirac también desarrolló la ecuación de Dirac, un artefacto matemático que describe el comportamiento de los electrones.

Para muchos, esta es la ecuación más bella de la física por su sencillez y por la complejidad de lo que representa, ya que de esta forma tan elegante, esta fórmula explica el increíble fenómeno del entrelazamiento cuántico y acabaría prediciendo la existencia de la antimateria y los positrones, ahí es nada. Un hallazgo a la altura de la teoría general de la relatividad. Impresionante.

Dirac consideraba que algunas de sus fórmulas eran demasiado bellas matemáticamente para ser erróneas.

Si quieres saber más sobre el increíble fenómeno del entrelazamiento cuántico y de cómo se transmite información de manera más rápida que la velocidad de la luz, te recomiendo que veas este vídeo:

A modo de comparación, Einstein paso gran parte de su vida intentando unificar la Teoría General de la Relatividad con la Mecánica Cuántica, pero nunca pudo ir más allá de la unificación de la Mecánica Cuántica con la Teoría Especial de la Relatividad que ideó Paul Dirac.

Por si fuese poco, Dirac inventó la notación para los sistemas cuánticos o la función Delta de Dirac, función que todo estudiante de ingeniería de telecomunicación conocerá.

🧑🏻⚕️ Un hombre extraordinario

Dirac era considerado como excéntrico y taciturno entre sus compañeros, de hecho, muchos pensaban que sufría el síndrome de Asperger. Se cuenta que, tras después de leer rápidamente Crimen y Castigo de Dostoevsky, alguien le preguntó su opinión sobre el libro, a lo que literalmente respondió:

“The author made a mistake, the sun set twice on the third chapter.”

Pese a su especial personalidad, Dirac era tremendamente altruista y arriesgo su propia seguridad para ayudar a otros científicos a escapar de Europa durante la II Guerra Mundial.

Afortunadamente, Dirac tuvo reconocimiento durante toda su carrera, ganó el Premio Nobel en 1933 (que compartió con Schrödinger) y se convirtió en una referencia para toda una generación de científicos. Como ejemplo, en la imagen de abajo se ve al celebérrimo Richard Feynman hablando con su héroe: Paul Dirac.

¿Cómo es posible que alguien tan brillante e influyente sea tan poco conocido? Es un misterio para mí.

📭 El sueño de Dirac

Usar la mecánica cuántica para entender de manera predictiva la biología y la química ha sido el sueño de los físicos desde hace casi un siglo. Y, en parte, esto es debido a esta famosa frase de Dirac:

The underlying physical laws necessary for the mathematical theory of a large part of physics and the whole of chemistry are thus completely known, and the difficulty is only that the exact application of these laws leads to equations that are much too complicated to be soluble. It therefore becomes desirable that approximate practical methods of applying quantum mechanics should be developed, which can lead to an explanation of the main features of complex atomic systems without too much computation.

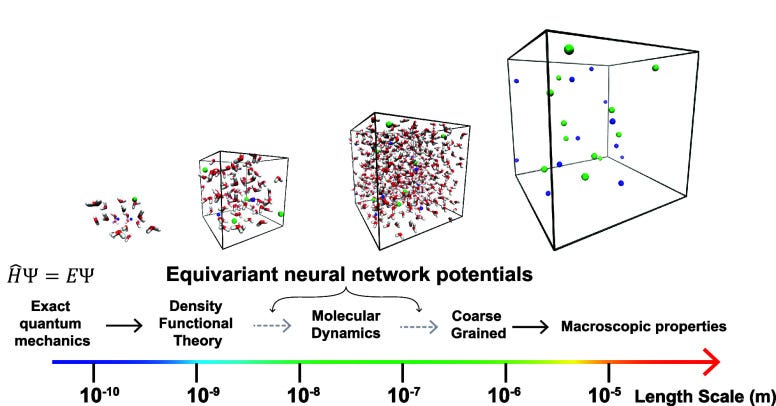

En este paper de Timothy T Duignan, un profesor de la Universidad de Queensland, publicado en Marzo de este año, el autor plantea una interesante línea de trabajo.

En la opinión del autor, la disciplina de la química va a experimentar una profundísima transformación, guiada principalmente por la combinación de los avances en química cuántica y en machine learning. De manera específica, se menciona las NNPs (Neural Network Potentials), una nueva arquitectura de red neuronal que ya está permitiendo simular sistemas a nivel molecular con una velocidad y precisión sin precedentes, basándose simplemente en leyes físicas fundamentales.

El desarrollo de este nuevo campo de investigación podría conseguir que, por fin, el sueño de Dirac de unificar la física y la química usando la mecánica cuántica se haga realidad. Esa unificación sería tanto un fin en sí misma como un medio, ya que sería una herramienta para generar nuevo conocimiento sobre biología, materiales y multitud de otras ramas de la ciencia mediante la conexión del mundo microscópico con el macroscópico.

Esta época de simulaciones moleculares otorgarán una cantidad encomiable de nuevos datos de entrenamiento que se podrán usar para construir modelos computacionales de manera automática para el diseño y optimización de sistemas a nivel molecular.

Conseguir esto sería el mejor regalo de agradecimiento que la humanidad le podría dar a Dirac. Realmente se lo merece. Eso sí, lo que él nunca hubiera podido imaginar es que este conocimiento fuese a ser generado por máquinas y no directamente por humanos.

¡Gracias como siempre por leer hasta aquí!

¿Te gusta The Independent Sentinel? ¡Ayúdame a difundirlo!

Si tienes comentarios o quieres iniciar una conversación, recuerda que puedes hacerlo aquí.

Si te has perdido alguna edición de la newsletter o quieres volver a leerlas, puedes acceder a todas aquí.

Si quieres escuchar todas las canciones de The Independent Sentinel, echa un vistazo a esta lista de Spotify.