The Independent Sentinel #15

Las bases matemáticas del Deep Learning, emperadores romanos y el origen de las Redes Neuronales

¡Hola!

Soy Javier Fuentes, bienvenido una vez más a The Independent Sentinel, la newsletter que hemos creado en Akoios para hablar de todo lo relacionado con la Ciencia de Datos.

Si aún no estás suscrito, puedes hacerlo fácilmente pulsando en el botón de abajo:

En esta edición hablaremos de los conceptos matemáticos detrás del Deep Learning, de la apariencia de los emperadores de la antigua Roma y de la primera máquina capaz de tener sus propias ideas.

¡Comenzamos!

🎼 ¿Quieres banda sonora? ¡Dale al Play!

1. Ciencia de Datos

🧮 Las bases matemáticas del Deep Learning

Una pregunta que se repite mucho en el mundo de la Ciencia de Datos es si es necesario saber matemáticas para poder dedicarse profesionalmente a esta disciplina.

Con todos los avances que estamos viviendo en los últimos años en los que, por ejemplo, es posible usar una Red Neuronal compleja con unas pocas líneas usando Keras + Tensorflow, podría parecer que basta con saber programar y algunas ideas básicas sobre Machine Learning para manejarse en el sector:

model = Sequential([

Dense(32, activation='relu', input_shape=(10,)),

Dense(32, activation='relu'),

Dense(1, activation='sigmoid'),

])

model.compile(optimizer='sgd',loss='binary_crossentropy',

metrics=['accuracy'])Creando una red neuronal con apenas unas líneas de código

Lamentablemente, las cosas no son tan sencillas como podría parecer. Si realmente queremos saber qué estamos haciendo y queremos tener la capacidad de profundizar en los problemas y en las soluciones a desarrollar, se antoja imprescindible tener ciertas nociones matemáticas.

¿Qué es lo que se debería saber entonces? En este fantástico artículo, el autor nos da muchas pistas de los conocimientos que idealmente un Científico de Datos debería tener.

De manera general, las disciplinas matemáticas a conocer son: Cálculo, Álgebra Lineal y Teoría de la Probabilidad, tres áreas que casi cualquier ingeniero habrá cursado en sus primeros años de carrera.

Veamos brevemente cada uno de estos pilares:

∫ Cálculo

En el fondo, una Red Neuronal no es más que representación de una función muy compleja compuesta a partir de varias funciones simples (las capas de la red).

Siguiendo esta línea de razonamiento, una Deep Neural Network, es una red compuesta por muchas capas, esto es, muchas funciones sencillas distintas.

Teniendo en cuenta por otra parte que el cálculo consiste en el estudio de la integración y diferenciación de funciones, ya tenemos la conexión entre el cálculo y el Deep Learning.

El primer pilar: El cálculo. Fuente

⟪ ⟫ Álgebra Lineal

Como acabamos de ver, las Redes Neuronales son funciones entrenadas usando la herramientas que nos proporciona el cálculo. Pese a ello, la herramienta que usamos para representar las redes en el Álgebra Lineal usando conceptos como la multiplicación matricial.

Además de esta aplicación específica del Álgebra Lineal para Deep Learning, esta disciplina tiene una grandísima importancia en muchos otros ámbitos del Machine Learning.

El segundo pilar: El álgebra lineal. Fuente

🎲 Teoría de la Probabilidad

Por último, tenemos la Teoría de la Probabilidad que estudia los fenómenos aleatorios y estocásticos. En muchas ocasiones en la Ciencia de Datos, se trabaja con cantidades aleatorias o estocásticas, de ahí la importancia de los conceptos básicos probabilidad y estadística para el desarrollo de los modelos.

El tercer pilar: La teoría de la probabilidad. Fuente

⚙️ Caso de Uso

Como hemos visto en alguna otra edición de The Independent Sentinel, el Machine Learning nos puede ayudar a mejorar, colorear o restaurar imágenes y vídeos.

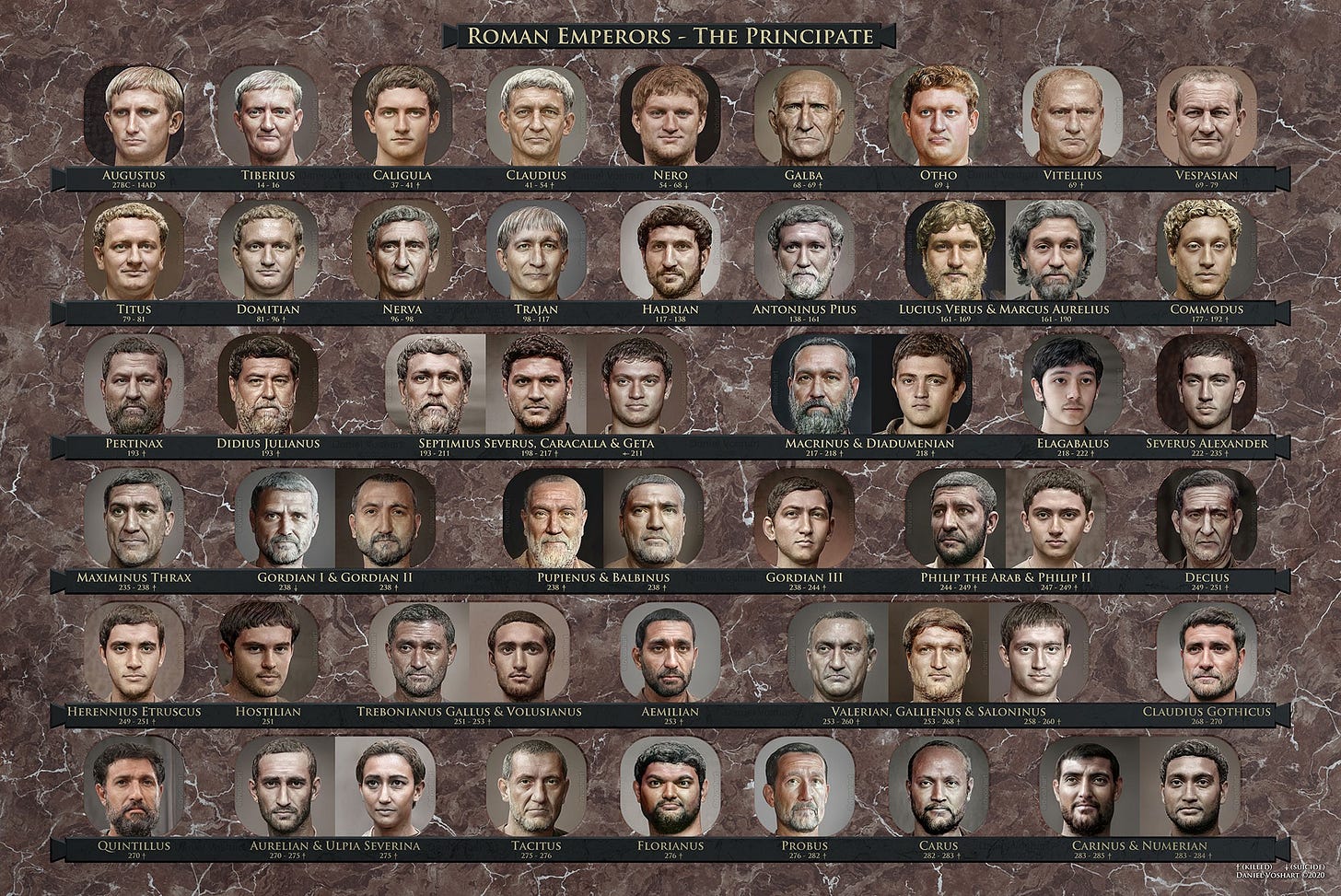

Recientemente, el diseñador Daniel Voshart ha ido un poco más allá en el uso del Machine Learning para ilustrar mejor el pasado.

Usando la herramientas de Redes Neuronales Artbreeder, PhotoShop y documentación histórica, ha conseguido generar retratos fotorrealistas de los Emperadores Romanos.

Usando más de 800 imágenes de bustos, ha recreado a los 54 Emperadores del Principado (Del 27 AC al 285 DC). El resultado es realmente impactante:

Reconstrucciones de Augusto (izd) y de Maximino el Tracio (der). Fuente

En esta preciosa infografía, se pueden ver todas las reconstrucciones:

Los Emperadores del Principado. Fuente

2. Historias 📔

El Perceptrón: La primera máquina capaz de tener ideas propias

A todos aquellos que se hayan acercado en algún momento a la Ciencia de Datos, seguramente les suene familiar el concepto de Perceptrón.

El Perceptrón es la red neuronal más básica de aprendizaje supervisado que se puede construir que puede verse como una red neuronal de una sola capa. Su arquitectura es la siguiente:

Arquitectura de un Perceptrón

Siendo:

x₁ … xn: Entrada a la red neuronal

w₁ … wn: Los “pesos” de la red

Σ: Función de agregación

F: Función de activación (puede ser, por ejemplo, una función sigmoide)

⏳ El origen del Perceptrón

El Perceptrón no es algo nuevo. Viajemos 62 años atrás en el tiempo hasta 1958.

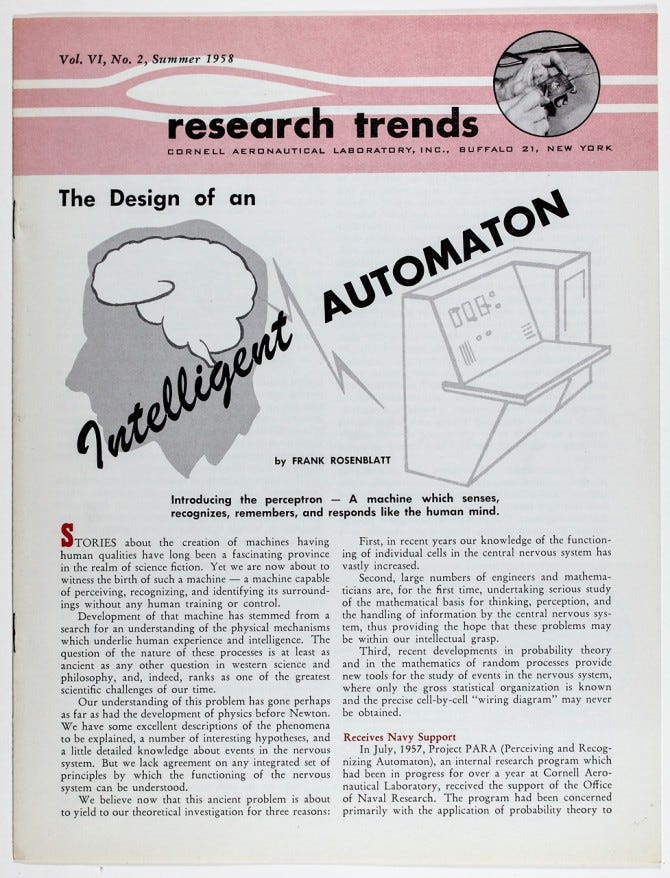

En ese año, Frank Rosenblatt, un investigador en psicología e ingeniería de proyectos en el Laboratorio Aeronaútico de la Universidad de Cornell (Nueva York), escribió unas líneas premonitorias respecto a algo que le obsesionaba: la creación de una máquina capaz de pensar.

“Stories about the creation of machines having human qualities have long been a fascinating province in the realm of science fiction” (…) “Yet we are about to witness the birth of such a machine – a machine capable of perceiving, recognizing and identifying its surroundings without any human training or control.”

Rosenblatt no se conformó con hacer esta predicción, sino que decidió demostrarla empíricamente mediante un dispositivo electrónico inspirado en los avances en biología y neurología llevados a cabo por Santiago Ramón y Cajal y Charles Scott Sherrington.

En Julio de ese mismo año, la Oficina de Investigación Naval de los EE. UU. sacó a la luz un excepcional avance liderado por Rosenblatt.

Habían conseguido que una computadora IBM 704 -con un peso aproximado de 5 toneladas- pudiese distinguir, tras un entrenamiento con tarjetas perforadas, cuáles de ellas estaban marcadas a su derecha y cuáles a su izquierda. Todo esto de manera autónoma y sin intervención humana.

El mismísimo Rosenblatt en una de sus investigaciones

Rosenblatt escribió una artículo en la revista de la Universidad de Cornell hablando sobre el autómata inteligente en el que estaba trabajando.

El anuncio de esta máquina causo cierto revuelo fuera de la Universidad, ya que, publicaciones como el New Yorker, se hicieron eco de la noticia con un titular muy llamativo:

“NEW NAVY DEVICE LEARNS BY DOING: Psychologist Shows Embryo of Computer Designed to Read and Grow Wiser”

Impulsado por este hito, Rosenblatt se enfocó en la construcción de una primera versión de su Perceptrón. Hablo de construcción ya que, aunque el Perceptron era inicialmente un algoritmo (puro software), la visión y medios de la época llevaron a Rosenblatt a construir un dispositivo físico (hardware) para demostrar sus tesis: El Perceptrón Mark I.

El Perceptrón Mark 1 y su obvia complejidad física

El Perceptrón Mark 1 fue diseñado para reconocimiento de imágenes y usaba 400 fotocélulas conectadas a las neuronas a modo de una sencilla red neuronal de una sola capa, como se muestra -a modo de ejemplo simplificado- en esta imagen:

Fuente: analyticsindiamag.com

Los más curiosos, podéis leer aquí el manual original de funcionamiento del Mark I.

El Perceptrón desencadenó una expectativas inmensas en la época en lo relativo a la Inteligencia Artificial, ya que todo parecía indicar que las máquinas con capacidad de pensar estaban más cerca de lo que todo el mundo creía.

Sin embargo, la falta de avances en los años posteriores en este campo fue enfriando estas expectativas, la financiación cayó en picado y, finalmente, se entró en el periodo llamado “The AI Winter” (del que hablaremos en detalle en otra edición) en el que se ralentizaron durante casi dos décadas (hasta finales de los 80) los avances en el campo de la Inteligencia Artificial.

Pese a todo, el tiempo ha reivindicado la visión de Rosenblatt. Los fundamentos de su Perceptrón han sentado las bases de la revolución de Deep Learning que estamos viviendo actualmente.

Debido a su prematura muerte, Rosenblatt no pudo llegar a ver que, usando su Perceptrón a escalas muy distintas (usando cientos o miles de capas en vez de solo una), es efectivamente posible crear modelos con capacidad de aprender y de demostrar cierta inteligencia específica.

Los avances en tecnología y disponibilidad de datos nos han permitido llevar al extremo los conceptos de Rosenblatt, y estamos viendo ahora las máquinas inteligentes con las que soñaba, eso sí, 60 años después que él.

Veremos qué nos deparan los siguientes 60 años en el campo del Deep Learning. Personalmente, ¡no me atrevo a hacer ninguna predicción!

¡Gracias como siempre por leer hasta aquí!

¿Estás disfrutando con The Independent Sentinel? Ayúdanos a que más gente nos conozca compartiendo nuestra publicación con todos aquellos apasionados de la Ciencia y la Tecnología cercanos a ti.

Si tienes comentarios o quieres iniciar una conversación, recuerda que puedes hacerlo al final de la publicación.

Si te has perdido alguna edición de la newsletter, puedes leer todas aquí.

👉 Si quieres conocer mejor cómo funciona nuestra tecnología Titan, no te pierdas nuestra serie de tutoriales publicados en Medium.

👉 Si te interesa, puedes solicitar un acceso gratuito para probar Titan aquí https://lnkd.in/gPz-2mJ