The Independent Sentinel #12

El sonido de las imágenes, GPT-3 y el teorema de la incompletitud de Gödel

¡Hola!

Soy Javier Fuentes, de Akoios, gracias por estar leyendo esta nueva edición de The Independent Sentinel, la newsletter en la que se habla (entre otras cosas) de Ciencia de Datos, Inteligencia Artificial y Machine Learning.

Si quieres suscribirte para recibir por correo cada edición, puedes hacerlo aquí:

En esta edición hablaremos del sonido de las imágenes, de GPT-3 y de Kurt Gödel, uno de los genios matemáticos del Siglo XX.

¡Comenzamos!

🎼 ¿Quieres banda sonora? ¡Dale al Play!

👉🏻Si te gusta la música de The Independent Sentinel, puedes escuchar todas las canciones aquí:

1. Ciencia de Datos

Casos de Uso 📈

Aunque no es un caso estricto de Inteligencia Artificial cómo los que solemos mostrar y aunque no es de rabiosa actualidad (es un estudio de 2014), no puedo dejar de escribir sobre esta investigación.

Tal y como se cuenta en esta noticia, investigadores del MIT, Adobe y Microsoft desarrollaron un algoritmo capaz de reconstruir una señal de audio analizando las vibraciones de un determinado objeto.

Tal y como muestran en el estudio, fueron capaces de recuperar sonido inteligible (una voz humana) a partir de cómo vibraba una simple bolsa de patatas. Lo mejor es el ver el vídeo para dónde explican varios de estos experimentos:

Sin duda, esto es el sueño de cualquier agencia de espionaje🕵🏻♂️. De hecho, hay quienes dicen que ciertos organismos llevan usando estas técnicas desde hace más de 50 años con técnicas de interferometría láser.

Herramientas 🛠

Si hay un campo de la Inteligencia Artificial que está avanzando rápido actualmente, no es otro que el del Procesamiento del Lenguaje Natural (NLP - Natural Language Processing).

Los trabajos más recientes en este campo apuntan en la dirección de que se pueden conseguir muy buenos resultados en este ámbito mediante el siguiente enfoque:

Paso 1: Entrenar modelos de forma no supervisada con un enorme conjunto de datos generalista.

Paso: Realizar un ajuste fino en función de la tarea específica a realizar (traducción, obtención de respuestas) usando pequeños conjuntos de datos específicos.

En 2018, OpenAI lanzó la primera versión de su modelo GPT, un modelo generativo pre-entrenado, capaz de conseguir resultados de calidad comparable respecto a modelos específicos en muchas tareas NLP.

Tanto este modelo como su sucesor (el GPT-2), son dos adaptaciones de una invención de Google de 20017 denominada Transformer, una novedosa red neuronal cuya arquitectura está especialmente diseñada para facilitar la comprensión del lenguaje.

De forma muy simplificada, el Transformer usa una función para calcular la probabilidad de que una palabra pueda aparecer en un texto en función de las palabras ya presentes.

👉🏻 Aquí puedes probar este tipo de modelos con las frases que prefieras 🤓

El lanzamiento de GPT-2 no estuvo exento de polémica ya que OpenAI anunció inicialmente que no iba a liberar el código fuente ya que, de caer en las manos equivocadas, podría ser usado, por ejemplo, para la generación de fake news:

Due to our concerns about malicious applications of the technology, we are not releasing the trained model. As an experiment in responsible disclosure, we are instead releasing a much smaller model for researchers to experiment with, as well as a technical paper.

Cabe decir que, pese a todo, el código acabo siendo liberado y OpenAI ha seguido trabajando en este ámbito hasta hoy. De hecho, hace apenas unos días, se liberó GPT-3, la nueva versión de esta serie de modelos.

A modo comparativo, el modelo GPT inicial de 2018 constaba de 110 millones de parámetros, el modelo GPT-2 de 2019 de 1,5 billones de parámetros y, esta última versión, cuenta con la friolera de 175 billones de parámetros.

Fuente: https://mc.ai/gpt-3-the-new-mighty-language-model-from-openai-2/

Se estima que el entrenamiento de esta red ha tenido un abrumador coste computacional valorado en más de 12 millones de dólares 😱

Como no podía ser de otra manera, este modelo ha generado cierta controversia, tal y como se puede ver en Hacker News. Cómo se indica en uno de los comentarios, un cerebro humano cuenta con más de 100 trillones de sinapsis, lo que es “sólo” tres órdenes de magnitud mayor que el modelo GPT-3. Dado que OpenAI ha tardado apenas un año y medio en incrementar en dos órdenes de magnitud el número de parámetros (de GPT-2 a GPT-3), parece que no estamos tan lejos de llegar a redes del orden de trillones.

Para ver cómo funciona GPT-3, no hay nada mejor que usar un ejemplo. Si le proporcionas como entrada esta frase sacada de la novela 1984 de George Orwell:

“It was a bright cold day in April, and the clocks were striking thirteen”

El modelo es capaz de “entender” el vago tono futurista y oscuro y es capaz de generar automáticamente esta continuación:

“I was in my car on my way to a new job in Seattle. I put the gas in, put the key in, and then I let it run. I just imagined what the day would be like. A hundred years from now. In 2045, I was a teacher in some school in a poor part of rural China. I started with Chinese history and history of science.”

Impresionante 🤯

Si GPT-2 era considerado peligroso y, cómo se ve justo arriba, GPT-3 bien podría pasar el Test de Turing. ¿Qué será posible hacer con un modelo de trillones de parámetros?

2. Historias 📔

El teorema de la Incompletitud

🌏París (Francia) 📅Agosto de 1900.

En el verano de 1900 tenía lugar en París el Segundo Congreso Internacional de Matemáticos. En este encuentro, el reputado matemático David Hilbert planteó en su intervención una lista de veintitrés problemas matemáticos a resolver.

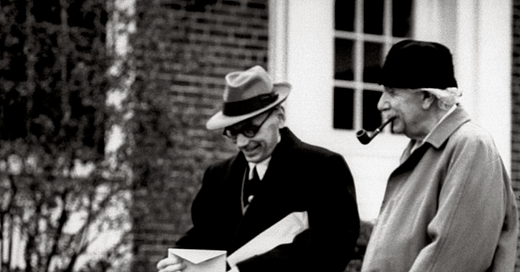

David Hilbert pensando fuerte.

Tal fue el impacto de esta lista que muchos consideran a Hilbert el arquitecto de la matemática moderna. En gran medida, estos 23 problemas han marcado el devenir de toda la investigación matemática que ha tenido lugar desde entonces.

Una de las obsesiones de Hilbert era probar la consistencia y robustez de las matemáticas, esto es, poder fundamentar todas las teorías sobre un conjunto finito de axiomas. Por ello, el segundo de los problemas de Hilbert planteaba lo siguiente:

Problema #2. La compatibilidad de los axiomas de la aritmética:

Demostrar que los axiomas no son contradictorios; es decir, demostrar que basándose en los axiomas no se podrá llegar jamás a resultados contradictorios mediante un número finito de deducciones lógicas

Viajemos por un momento algunos años al futuro:

🌏Princeton (Nueva Jersey) 📅 Mediados de la década de 1930

En estos años, era común ver pasear por Princeton al que, con toda seguridad, era el científico más famoso de la época: Albert Einstein.

De manera recurrente, un misterioso joven comenzó a acompañar a Einstein en sus paseos. Este joven se llamaba Kurt Gödel y había llegado a Estados Unidos escapando del Tercer Reich. En su caso, no por ser judío como Einstein, sino para evitar ser reclutado como soldado en el ejército Nazi.

¿Quién era Kurt Gödel y por qué Einstein disfrutaba tanto de su compañía? Volvamos atrás en el tiempo unos pocos años.

🌏Königsberg (Sí, dónde los 7 puentes) 📅 1930

En 1930, se celebró un congreso matemático en la ciudad de Königsberg que, casualmente, era la ciudad natal de Hilbert.

Casi a la finalización del congreso, un tímido joven reunió todo el coraje que le fue posible para alzar su mano para intervenir. Este joven era Kurt Gödel y tenía algo muy importante que contar.

Gödel presentó en este foro por primera vez su “Teoría de la incompletitud”, que echaba por tierra el sueño Hilbertiano de crear un cuerpo axiomático consistente. Según Gödel, ningún sistema podría ser a las vez consistente, recursivo y completo o, dicho de otro modo, hay cosas que, aún por certeras que sean, no podremos nunca demostrar.

La teoría de Gödel traía consigo consecuencias sísmicas para las matemáticas ya que arruinaba la esperanza de demostrar que las matemáticas eran una disciplina segura y reducible a axiomas básicos incuestionables.

Gödel probó que:

En cualquier sistema formal axiomático consistente que pueda expresar hechos sobre aritmética básica hay enunciados verdaderos que no se pueden probar dentro del sistema y

que la consistencia misma del sistema no puede ser probada dentro de ese sistema.

Estos teoremas de la incompletitud son complejos de entender y terriblemente contraintuitivos. Cómo se preguntaba Russell tras conocer las teorías de Gödel:

¿Debemos pensar que 2 + 2 no es 4 sino 4,001?"

Lo interesante del trabajo de Gödel es que usó la matemática (meta-matemática) para probar que no todo es demostrable dentro de las matemáticas.

Con ello, cambió para siempre el modo en el que entendemos qué son las matemáticas y los límites de lo que podemos llegar a saber.

📅 1940 - 2020

El trabajo de Gödel le dio la oportunidad de emigrar a América y de entablar una profunda amistad con Einstein.

Además, su trabajo inspiró a genios de la talla de John von Neumann y Alan Turing, dos de los padres de las ciencias de la computación.

En este sentido y acercándonos a nuestro terreno, el trabajo de Gödel ha tenido igualmente una gran influencia en la computación ya que ha ayudado a entender cuáles son los límites de aquello que se podría resolver una computadora.

Cómo se puede intuir, todo esto influye la Inteligencia Artificial y el Machine Learning al ser disciplinas tan fuertemente vinculadas a las matemáticas.

En este artículo elaborado a cabo por un equipo internacional de matemáticos e investigadores en IA han descubierto que, pese al aparentemente ilimitado potencial del Machine Learning, incluso los algoritmos más sofisticados están sujetos a los límites de la matemática.

Entender lo que una máquina podría aprender es uno de los objetivos a resolver en el Machine Learning pero, según explican en el paper, la habilidad de una máquina para aprender (learnability) no puede ser probada o refutada usando los axiomas de las matemáticas. Como vemos, las matemáticas y el Machine Learning comparten un mismo destino en este sentido.

Gödel nos dejó una idea terriblemente inquietante. La idea de que no podemos estar completamente seguros de que A no es igual a B.

Esto es desolador desde el punto de vista racionalista ya que viene a decir que un sistema consistente no puede probar su propia consistencia y que, de un modo un otro, tenemos que hacer un salto de fe para creer que todo lo que hacemos tiene sentido.

¡Gracias por leer hasta aquí!

¿Disfrutas The Independent Sentinel? ¡Compártelo!

¿Te has perdido alguna edición? Puedes leer todas aquí:

👉 Si quieres conocer mejor cómo funciona nuestro producto Titan, no te pierdas nuestra serie de tutoriales publicados en Medium.

👉 Si quieres, puedes solicitar un acceso gratuito para probar nuestro producto aquí https://lnkd.in/gPz-2mJ